Производство

Внедрение технологий ИИ в производственные отрасли — это еще один шаг к повышению эффективности, снижению издержек и устойчивому будущему. ИИ стремительно трансформирует существующие производственные процессы, делая их более безопасными, экономичными, быстрыми, точными и гибкими.

Перечислим лишь несколько ключевых направлений применения ИИ в производстве:

Автоматизация рутинных задач

Автоматизация процессов, протекающих в опасных средах

Прогнозирование неисправностей оборудования (предиктивная диагностика)

Выявление дефектов продукции на этапе производства

Оптимизация логистики, управление цепочками поставок

Контроль качества продукции на стадии производства

Моделирование и цифровые двойники

Оптимизация потребления ресурсов (электроэнергии, воды и т. д.)

ИИ позволяет предприятиям повышать производительность труда и снижать издержки.

Однако, помимо очевидных преимуществ, внедрение ИИ в производственные процессы привносит и дополнительные риски, требующие особого внимания к вопросам кибербезопасности и надежности систем ИИ [1, 2].

Основные источники рисков для систем ИИ в производстве

- Традиционные кибератаки, направленные на взлом систем ИИ с целью саботажа производства или кражи данных.

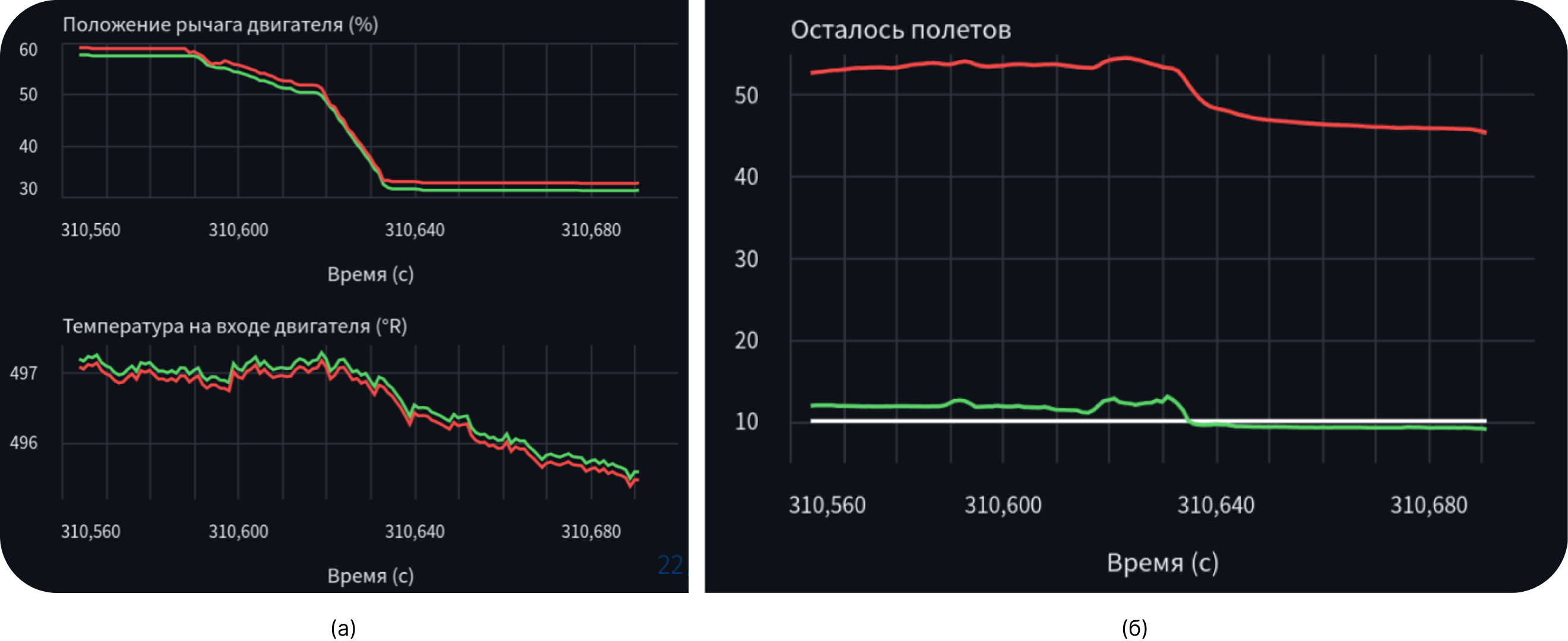

- Уязвимости в моделях и алгоритмах ИИ. Например, в результате вредоносных

манипуляций с входными данными (состязательные атаки [4, 5, 6]) модель

прогнозирования деградации оборудования может выдавать неверные прогнозы (Рис.

1), что приведет к избыточным затратам на обслуживание или к аварии.

Рис. 1 - Пример состязательной атаки на систему прогнозирования деградации турбовентиляторного авиационного двигателя (датасет NASA C-MAPSS-2 Turbofan Engine Degradation Simulation Data Set-2, https://paperswithcode.com/dataset/nasa-c-mapss-2): а) чистые (зеленый график) и атакованные (красный график) входные данные на примере двух показателей (признаков) – положение рычага двигателя и температура на входе двигателя; б) предсказание оставшегося числа вылетов до проведения технического обслуживания двигателя на чистых (зеленый график) и атакованных (красный график) данных, истинное значение – белый график.

- Смещенность в обучающих данных, которая может возникать как преднамеренно, в результате атаки на систему ИИ, так и непреднамеренно, из-за недостаточного понимания разработчиками системы ИИ возможных источников смещения. Проблеме борьбы со смещенностью данных в системах ИИ посвящен отдельный стандарт [3].

- Дрейф данных, т.е. постепенное изменение статистического распределения входных данных по сравнению с распределением данных в обучающем наборе, или поступление «примеров вне распределения», т.е. данных, сильно отличающихся от тех, на которых была обучена модель.

- Угрозы физической безопасности персонала и сохранности оборудования. Например, робот-погрузчик не заметил человека в рабочей зоне и нанес ему травму или ремонтный робот повредил оборудование в процессе технического обслуживания. В эту категорию также можно отнести риски возникновения противоречий между решениями человека и ИИ. Так, из соображений «оптимизации», ИИ может заблокировать аварийное отключение оборудования.

Важно обратить внимание на еще один риск, специфичный для промышленного применения ИИ в ряде областей. Это отложенный эффект от ошибок ИИ. Например, если ИИ управляет настройкой некоторого технологического процесса (скажем, формированием состава сплава или какого-то химического раствора), допуская при этом небольшие погрешности, то последствия могут проявиться уже в конечной продукции через месяцы или даже годы.

Исходя из перечисленных рисков, безопасность ИИ в производстве выходит за рамки традиционной защиты ИТ-систем. Оно требует комплексного подхода, включающего как традиционные меры кибербезопасности, так и меры противодействия угрозам, специфичным для ИИ. Необходимо контролировать безопасность цепочек поставки данных для ИИ [7], обеспечивать устойчивость алгоритмов к вредоносным воздействиям, а также проводить постоянный мониторинг работы моделей на предмет возникновения аномальных результатов. Только так можно гарантировать, что ИИ будет не просто мощным, но и безопасным инструментом автоматизации производственных процессов.

Список источников

Развернуть список источников

- 1. ПНСТ 776-2022. Информационные технологии. Интеллект искусственный. Управление рисками.

- 2. ПНСТ 836-2023. Искусственный интеллект. Функциональная безопасность и системы искусственного интеллекта.

- 3. ПНСТ 839-2023 (ISO/IEC TR 24027:2021). «Искусственный интеллект. Смещенность в системах искусственного интеллекта и при принятии решений с помощью искусственного интеллекта».

- 4. Szegedy C. et al. Intriguing properties of neural networks //arXiv preprint arXiv:1312.6199. – 2013.

- 5. Goodfellow I. J., Shlens J., Szegedy C. Explaining and harnessing adversarial examples //arXiv preprint arXiv:1412.6572. – 2014.

- 6. Madry A. et al. Towards deep learning models resistant to adversarial attacks //arXiv preprint arXiv:1706.06083. – 2017.

- 7. ГОСТ Р 70889-2023 «Искусственный интеллект. Структура жизненного цикла данных».