Мониторинг и контроль

Безопасная и эффективная работа современных индустриальных объектов и инфраструктуры все чаще требует непрерывного мониторинга и контроля происходящих на них процессов и ситуаций. В условиях стремительного роста объема регистрируемых при этом данных, которые в подавляющем числе случаев должны быть оперативно обработаны, технологии ИИ становятся не просто актуальным, но практически незаменимым инструментом в этой области.

ИИ может использоваться как в качестве помощника оператора системы мониторинга и контроля, так и непосредственно в качестве системы принятия решений, если это не сопряжено с рисками для человека или окружающей среды. К типовым задачам мониторинга и контроля, решаемым с помощью ИИ, можно отнести распознавание объектов, людей и ситуаций по данным камер видеонаблюдения (видеоаналитика), мониторинг производственных процессов на предприятиях с использованием телеметрии сенсоров, неразрущающий контроль объектов.

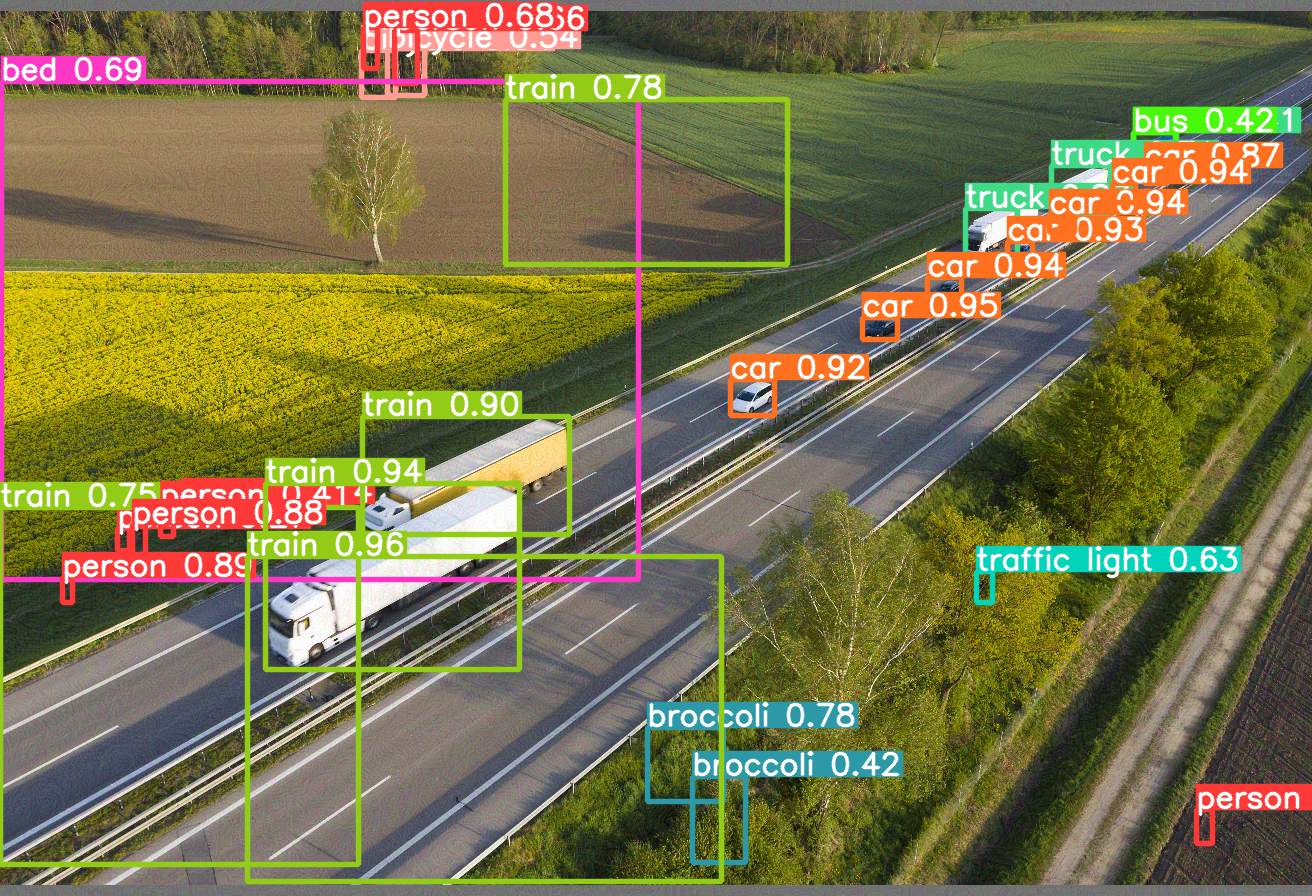

Пример работы системы видеонаблюдения для мониторинга дорожной инфраструктуры: исходное и обработанное изображения

Стандарты

Стандартизация ИИ для решения задач мониторинга и контроля уже находится в активной фазе разработки. В России можно отметить серию ГОСТ в области управления интеллектуальной транспортной инфраструктурой [1, 2, 3], ситуационной видеоаналитики [4], мониторинга поведения и прогнозирования намерений людей [5, 6], распознавания и определения типов объектов дорожно-транспортной сети [7, 8].

Нет сомнений, что в перспективе нескольких лет как в России, так и за рубежом безопасность систем ИИ для мониторинга и контроля получит надлежащую нормативную базу.

Направления угроз и потенциальные меры защиты

В соответствии с жизненным циклом систем ИИ, первым этапом является этап подготовки данных для обучения моделей ИИ. Данные должны удовлетворять стандартным требованиям, включающим достоверность, полноту, безопасность, несмещенность [9-11]. При этом любое отклонение от требований по формированию обучающих и валидационных данных ведет к рискам создания моделей ИИ низкой точности, достоверности, надежности и со слабыми обобщающими свойствами [10].

Для систем ИИ, выполняющих мониторинг людей, критически важными и обязательными являются требования конфиденциальности, этичности и защиты персональных данных. Наиболее жесткую позицию в этом вопросе занимает Европейский Союз (ЕС). В соответствии с Законом ЕС об искусственном интеллекте (EU AI Act) [12] ряд практик применения ИИ, прямо или косвенно связанных с мониторингом людей, отнесены к практикам с неприемлемым уровнем риска для прав и свобод граждан и запрещены к использованию в ЕС [13]. К запрещенным практикам относятся:

- создание или расширение баз данных для распознавания лиц путем нецелевого сбора изображений лиц с камер видеонаблюдения или из сети Интернет;

- определение эмоций в сферах трудовых отношений и образования;

- дистанционная биометрическая идентификация в общественных местах.

Далее следует этап создания и обучения модели ИИ, который крайне желательно проводить в защищенных программных средах и с использованием доверенного программного обеспечения. Особо отметим, что в задачах видеоаналитики большой популярностью пользуются свободно распространяемые модели семейства YOLO [14, 15], предназначенные для обнаружения и распознавания объектов на изображениях на основе глубоких нейронных сетей. Важно понимать, что использование «нейросетей, загруженных из Интернета», даже при условии дообучения или модификации модели, не гарантирует отсутствие модулей кражи персональных данных, триггеров перевода модели на незадекларированное поведение или иной вредоносной функциональности. Только тщательный анализ топологии и внутренней логики работы таких моделей может гарантировать их безопасность.

На этапе обучения модели ИИ должна быть предусмотрена ее защита от атак на входные данные [16], включая защиту от так называемых состязательных атак. Для задач видеоаналитики последний вид атак особенно актуален. Большинство состязательных атак направлено именно на отравление входного изображения с целью изменения вывода модели, причем отравленные изображения можно сделать практически визуально неотличимыми от исходных. Огромное количество успешных атак на входные данные, их разнообразие и даже возможность их таргетирования под определенные типы нейросетей представляют большую проблему и огромный вызов для методов защиты ИИ, к которым, в первую очередь, относятся методы состязательно обучения [17, 18].

Пример состязательной атаки на систему видеонаблюдения

После создания модели должно быть проведено её полноценное и всестороннее тестирование по определённой методологии [10], а в случае моделей, уязвимости которых представляют наибольшую угрозу, может быть назначено и внешнее тестирование экспертами по безопасности ИИ.

Залогом безопасности вашего ИИ-решения является понимание специфичных уязвимостей его компонент и внимательное следование всем рекомендациям и методологиям защиты ИИ.

Список источников

Развернуть список источников

- 1. ГОСТ Р 70985-2023. Системы искусственного интеллекта на автомобильном транспорте. Системы управления интеллектуальной транспортной инфраструктурой. Требования к испытанию алгоритмов распознавания автомобильных номеров.

- 2. ГОСТ Р 70984-2023. Системы искусственного интеллекта на автомобильном транспорте. Системы управления интеллектуальной транспортной инфраструктурой. Требования к испытанию алгоритмов прогнозирования дорожных условий.

- 3. ГОСТ Р 70983-2023. Системы искусственного интеллекта на автомобильном транспорте. Системы управления интеллектуальной транспортной инфраструктурой. Требования к испытанию алгоритмов прогнозирования характеристик транспортного потока.

- 4. ГОСТ Р 59385-2021. Информационные технологии. Искусственный интеллект. Ситуационная видеоаналитика. Термины и определения

- 5. ГОСТ Р 58776-2019. Средства мониторинга поведения и прогнозирования намерений людей. Термины и определения.

- 6. ГОСТ Р 59391-2021. Средства мониторинга поведения и прогнозирования намерений людей. Аппаратно-программные средства с применением технологий искусственного интеллекта для колесных транспортных средств. Классификация, назначение, состав и характеристики средств фото- и видеофиксации.

- 7. ГОСТ Р 70321.6-2022. Технологии искусственного интеллекта для обработки данных дистанционного зондирования Земли. Алгоритмы искусственного интеллекта для распознавания объектов дорожно-транспортной сети на космических снимках, получаемых с космических аппаратов оптико-электронного наблюдения. Типовая методика проведения испытаний

- 8. ГОСТ Р 70321.7-2022. Технологии искусственного интеллекта для данных дистанционного зондирования Земли. Алгоритмы искусственного интеллекта для определения типов объектов дорожно-транспортной сети на космических снимках, получаемых с космических аппаратов оптико-электронного наблюдения. Типовая методика проведения испытаний.

- 9. ГОСТ Р 70889-2023. Искусственный интеллект. Структура жизненного цикла данных.

- 10. ГОСТ Р 59898-2021. Оценка качества систем искусственного интеллекта. Общие положения.

- 11. ПНСТ 839-2023. Искусственный интеллект. Смещенность в системах искусственного интеллекта и при принятии решений с помощью искусственного интеллекта.

- 12. https://artificialintelligenceact.eu/

- 13. https://artificialintelligenceact.eu/article/5/

- 14. Redmon J. You only look once: Unified, real-time object detection //Proceedings of the IEEE conference on computer vision and pattern recognition. – 2016.

- 15. G. Jocher, A. Chaurasia, and J. Qiu, “YOLO by Ultralytics.” https://github.com/ultralytics/ultralytics, 2023. Accessed: February 30, 2023

- 16. ПНСТ 836-2023. Искусственный интеллект. Функциональная безопасность и системы искусственного интеллекта

- 17. I. Reyes-Amezcua, G. Ochoa-Ruiz, and A. Mendez-Vazquez, “Enhancing image classification robustness through adversarial sampling with delta data augmentation (dda),” in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2024, pp. 274–283.

- 18. Zhao M. et al. Adversarial Training: A Survey //arXiv preprint arXiv:2410.15042. – 2024.